在早前举行的CES 2019大会上,过去数年间一直在研发无线VR压缩技术的DisplayLink演示了一项名为“注视点压缩”的技术,同时给人留下了深刻的印象。他们指出,这项技术能够大大提高压缩效率,同时将原来所需的带宽降至三分之一。根据美国专利及商标局日前公布的一份最新专利,原来谷歌早在2017年7月就提交了与注视点压缩有关的专利申请。

延伸阅读:DisplayLink为无线VR演示“注视点压缩”技术,可将所需带宽降至1/3

大家或许不会对注视点渲染这个概念感到陌生:由于我们的眼睛只能在视场中心范围内看到高保真度内容,所以VR系统可以集中渲染注视点位置的图像,并降低外围视场的图像质量较低,从而降低整体系统的渲染消耗。对于这一点,眼动追踪可确保系统能够始终在用户视场中心渲染高质量图像。如果足够优秀,用户将完全不会察觉到任何的不同。

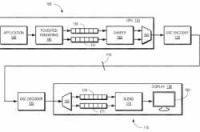

注视点压缩同样利用了类似的原理,谷歌在文件中写道:“处理单元配置为渲染代表图像高敏锐度区域的第一像素,以及代表图像低敏锐度区域的第二像素。塑形器配置为根据低敏锐度区域的至少一个维度重新组织第一像素。多路复用器配置为多路复用重新组织的第一像素和第二像素以形成显示数据流。编码器配置为压缩传输至显示器的显示数据流。解码器配置为解压缩显示数据流。解复用器配置为解复用第一像素和第二像素。另一个处理单元配置为混合第一像素和第二像素以形成表示图像的混合像素值。”

相关专利:Foveated Compression of Display Streams

简单来说,谷歌系统将利用眼动追踪把图像划分为中心注视点的高敏锐度区域和外围视场的低敏锐度区域,然后利用算法尽量保持高敏锐的原始像素,并重点解压缩低敏锐度区域,从而有效降低无线传输所需的带宽,并且提供中心注视点区域“几乎无损”的质量。

值得一提的是,谷歌研究院在2017年同样撰写了一篇名为 “Strategies for Foveated Compression and Transmission(注视点沿所与传输策略)”的论文。

另外,这篇论文的作者是负责谷歌VR渲染研究工作的Behnam Bastani,而Facebook已于2018年将其挖到了专注于沉浸式技术研究的Facebook Reality Lab。

原文链接:https://yivian.com/news/55604.html

来源:映维网